对话网易易盾人工智能教员组:一次消除歧视的尝试

从网站资讯推荐,到医疗保健系统,再到街头监控摄像,在现实世界中,算法无处不在,偏见与歧视也是如此,并带来了现实的负面影响。

算法歧视

什么是算法歧视?微软研究院巴罗卡斯(Solon Barocas)和加州大学洛杉矶分校法学院的塞布斯特(Andrew D.Selbst)在联合报告中认为,算法自动化决策可能给某些群体带来歧视性的不利结果。算法模型的所有思想都是外来的,来源于人类的经验。人工智能的研究对象模型存在严重的不确定性,即对深度学习的“黑盒子”知之甚少,且受训练投喂数据的影响较大。 当数据被错误使用,算法模型可能会进一步强化种族主义和性别歧视等刻板印象,得出带有偏见和歧视的错误结论。因此,偏见实际上来自于人类自身、技术瓶颈和数据误用,在让算法成为“决策者”之前,必须确保其拥有正确的价值观,否则就应该被丢弃。

流程图

多团队共同参与 AI 算法价值观的制定

网易智企旗下易盾利用 AI 技术赋能企业完成数字内容风控,也意识到了 AI 系统发展过程中的社会问题。当前,团队从数据收集、数据训练、模型搭建、标准制定等环节出发,有效消除偏见与歧视,在可信 AI “公平性”指标上积累了宝贵经验。

1、 标准让机器体系化、具体化判断

运营链接客户需求与算法标准的透明可解释性

谈到暴恐问题时,大家可能下意识会联想到某些民族与有色人种,这是由于受众在大环境和过往新闻的影响中产生“先入为主”的感知。此外,在大家认知中,穿着多少与胸的大小被纳入到“女性群体低俗与否”的考量中,即使这个女性什么也没有做,即使是同样的姿势与拍摄角度。 “哪怕告诉自己秉承客观的心态看待,每个人对事物的评判结果也是存在差异的。”负责制定 AI 判断标准的策略专家汪梦闪说。标准的制定是模型训练前的重要环节,涉及到两个方面,一个是针对数据收集的标准,另一个是针对算法模型的标准,最终目的是希望让算法模型尽可能客观地判断。 她在客户沟通中也发现,运营端从标准制定开始,就要去平衡原始需求,一个挑战在于客户需求向标准的转化如何能在满足需求的同时更加客观。部分独特的需求,本身就带有偏见的影子,不能直接照搬到模型训练中,需要去结合一些因素。 过程中,标准会被进一步细化、具体化与客观化,落实到泾渭分明的界限中,才不容易出现偏见。 “我们很难直接让机器去理解‘色情’、‘性感’是什么,一刀切就极易存在偏见,更客观的做法是细化、量化标准,如胳膊、胸部和腿部等身体部位的裸露。”汪梦闪介绍说,如果不给任何客观的描述和标签,仅凭个人感觉来判断“性感”,大概率的数据都是诸如身材姣好的女性之类。 为了避免标准固化,标准还须进行动态调整。2022 年的色情性感标准与 5 年、10 年前的标准相比,肯定有很大差异。例如,2021 年我国最高人民法院细化了未成年人淫秽色情物品识别标准,让未成年人免受“线上侵害”逐渐凸显出来。 AI 是人类的镜子,映射的是人类本来就存在的偏见与歧视,标准是人类偏见与歧视流向 AI 的另一个重要管道。在易盾,标准不是一个组或一个人决定,是运营、算法和标注三方跨团队的合作,避免有一方存在固化的思维。跨垂类的合作,能够更好地消除一些潜移默化的连自己都无从感知的偏见。

2 、 打标任务中的问题界定

标注人员在处理数据

“挺感动的吧,教出来了,至少有一个初中生的心智或智慧了,它有自己的判断,但还是会出错,这个时候就需要我们去调整。”任职于易盾数据标注部的孔杰激动地说。 孔杰在过去几个月先后标注了几万条“问题”数据,协助 AI 算法工程师完成欺诈模型的训练。过去,他和团队成员的任务各不相同,有的负责文本,有的负责图片,有的负责语音,一个共同点是给数字化内容打上标签,识别出其中的不良行为。人工智能的崛起催生了一系列新兴职业,数据标注员、AI 工程师、数据科学家等陌生的名词进入大众的视野。平日里,他们穿梭于机器模型与数据之间,职责在于让 AI 技术更好地服务于业务,又快又好地自动执行完一项项任务,代替重复的人力劳作。数据标注岗的工作任务就是辅助机器去学习任务,相当于人工智能的助教。在岗位上,孔杰首先要输出自己的判断,一遍遍不厌其烦地教育着工程师搭建的 AI 机器模型,让机器模型知道这些内容数据中存在这样或那样的问题。 判断本身就是难题,一个随意的结论,极有可能将人类的偏见,如种族主义、性别歧视、仇外心理、社会 经济 歧视、确认偏见等,带入算法模型中。 在欺诈用户识别的任务中,为了尽可能地提升公平性,“欺诈嫌疑”的落实,不仅需要多位人员的判断,也需要多个维度的查验,即多方审核制度。 孔杰负责多方审核中的第一层,通过排查发言数据与行为信息,严格排查数据中的引流、广告、联系方式变种等行为,对行为上有高嫌疑动作的用户打上“欺诈嫌疑”标签。接下来,还有其他人结合产品与其他实际情况进行判断,是“加黑”还是“退回”,多人多次筛选最终才得出结论。以引流为例,平台中有账号试图将用户引向 微信 或 QQ 等别的平台,甚至是拉到一些更隐秘、更小众的第三方交流点,对平台用户威胁极大。多层的数据标注,让机器逐渐懂得大致的判断标准。“其他方向的数据确实很多,机器除了识别问题用户,还可以筛掉一些正常用户,减少误判导致的用户投诉。”孔杰说。 分歧讨论是促进公平性的另一个契机。团队小心谨慎地对待每一次数据打标,存在分歧的困难标注任务往往要花了好几天时间才能解决。 成员们遇到多次打标不一致的数据,就得开展专题研讨会,直到达成统一的标准。“对于一个问题讨论,一开始分歧比较多,交流之后才能统一想法。”孔杰说。几期培训之后,形形色色的诈骗话术逐渐为模型所熟知,并能够举一反三、独立自主地决策,甚至有着超越一般人的诈骗洞察能力,不仅能从内容上拦截,也能从用户行为上进行分析。文字与图片中暗藏诈骗风险,但都过不了 AI 模型的“法眼”。

3 、 算法工程师全链路跟踪偏见

公平性是可信 AI 至关重要的要求之一

每分每秒,人工智能都在决定数字内容的去留,成为在 社交 网络空间的隐形决策者。 AI 系统中的不公平性也显著暴露出来,简单来说,就是作为人工智能大脑的“黑箱”中出现的各类偏见,如性别歧视、种族偏见、就业歧视、教育歧视、价格歧视、犯罪行为预测偏见等。易盾资深算法工程师崔若璇在可信 AI 的直播中提到,不少算法产生偏见问题在于所依赖的数据。 扫描二维码,回顾直播

随着人工智能的普及,美国开始使用 AI 算法来预测罪犯的犯罪行为。美国“为了人民”网站对 COMPAS 系统分析发现,该预测算法却对黑人有偏见:相比白人,黑人被告更容易被判断为有更高的累犯风险。 “这是因为算法都是基于历史犯罪统计数据来预测未来的犯罪行为。”崔若璇说。值得注意的是,上述预测算法很容易受到逮捕率的影响,根据美国司法部的数据,黑人被捕数的可能性是白人的两倍多。

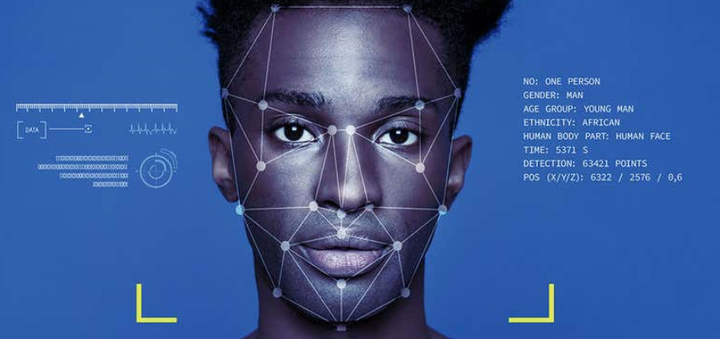

类似的事件还有不少,Google 公司的图像识别程序也曾将黑人标注成大猩猩;麻省理工学院将其用于训练 AI 系统的数据集“Tiny Images”永久下线,因其中带有许多涉及种族歧视、性别歧视、恋童癖等倾向的图像和标签;Amazon 公司的人力资源算法在分析应聘者时,一旦出现“女性”或“女性特征”就会降低应聘者排名;人脸识别在身份安全验证中日渐流行,但不公平性也逐渐显露。

哈佛大学的一项研究表明,大部分人脸识别算法具有高达 90% 以上的准确率,但是这一概率并不普遍,其中女性、黑人、18-30 岁的受试者有着较差的准确性。 “数据采集环节就得考虑数据在人种、性别、年龄等方面的多样性,否则可能引入偏见。”崔若璇表示,此外,训练过程不加以约束就会固化偏见,输出结果不加处理也会放过偏见,为了减少算法偏见,算法、工程、数据、运营、标注、产品团队的协力配合,每个环节都不能掉以轻心。崔若璇所在的算法团队对数据进行了相关预处理操作,尽量减少训练素材中的偏见因素,在模型搭建与训练过程中,引入了针对性的公平性量化指标,实时对训练过程进行监测和量化评估,避免偏见固化,主要可分为以下三个阶段:

首先,易盾 AI 实验室在数据收集阶段保证收集过程,全面、多样、及时更新,并且会结合一系列数据预处理、重采样等措施,达到“保质保量”的效果,在数据源头就保证尽可能地消除偏见。

其次,在模型训练阶段,引入公平性相关的量化指标,对其开展监测,并对模型的数据结果也进行公平性相关指标的考察和调整。

最后,在结果输出阶段,对输出结果进行“公平性的再判定”,尽量减少决策偏见。

在易盾,AI 技术被应用于数字风控,例如算法帮助人类审核内容及账户,快速识别风险,审核算法的公平性打造被放在突出位置。

结语

作家雪莱在科学幻想小说中提出了科学怪人的恐惧,人造人在被赋予智慧与意识之后,有了超出人们料想的诉求,就像当下的 AI 算法无意识产出的偏见与歧视一样。在人工智能盛行的今天,我们如何与之和谐共处仍留待我们探讨。